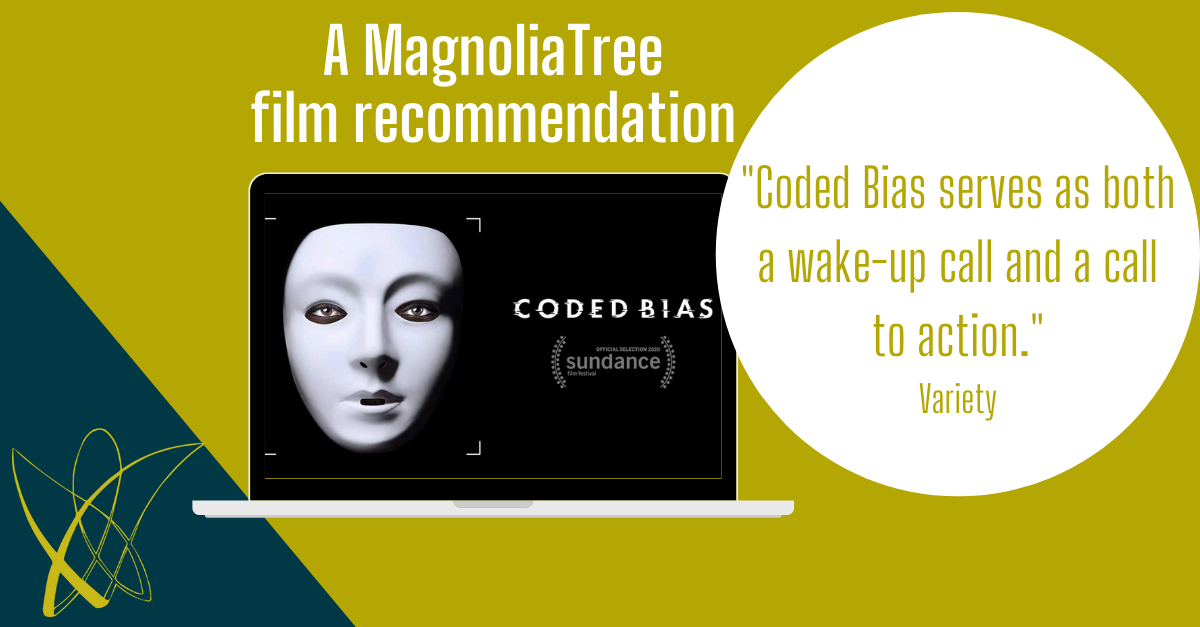

Haben Sie die neue Netflix-Dokumentation Coded Bias schon gesehen? Wenn nicht, sollten Sie das unbedingt nachholen.

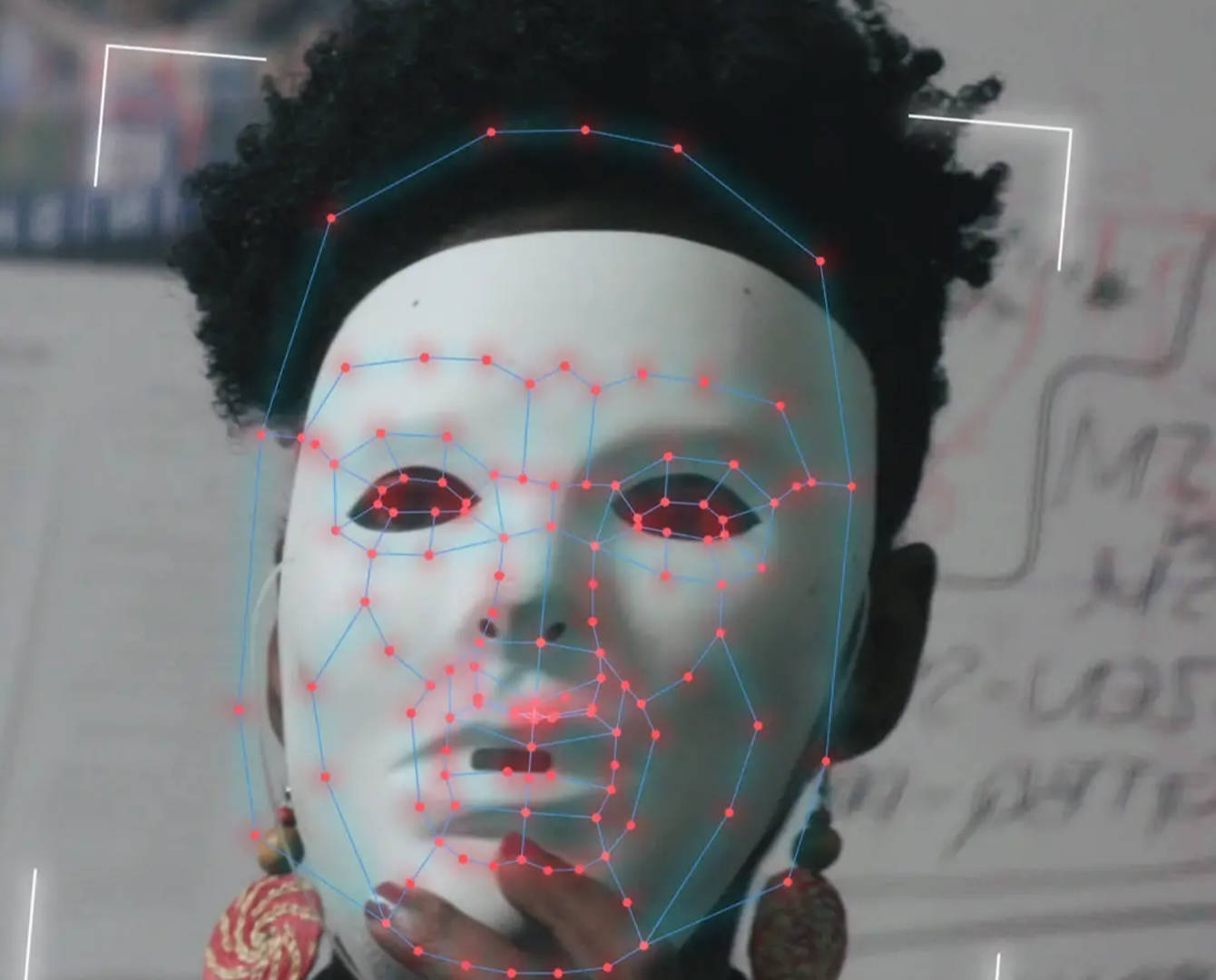

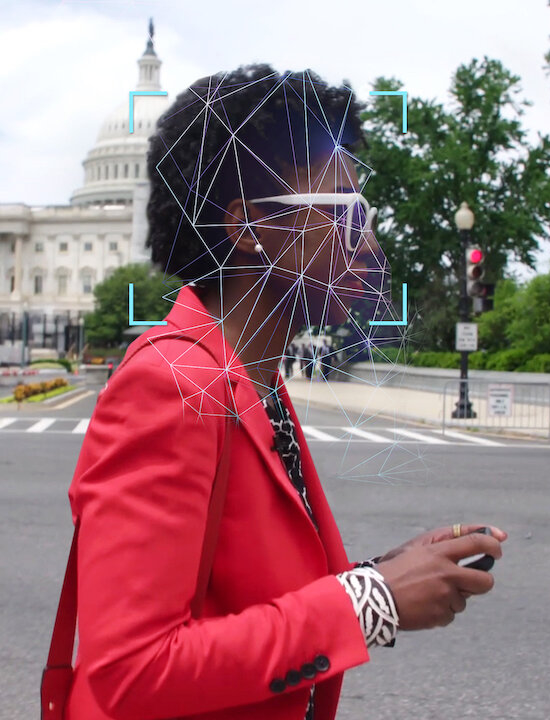

In diesem Dokumentarfilm folgt die Filmemacherin Shalini Kantayya der Informatikerin Joy Buolamwini vom M.I.T Media Lab und Datenwissenschaftler:innen, Mathematiker:innen und Watchdog-Gruppen auf der ganzen Welt, um die Diskriminierung durch Gesichtserkennungsalgorithmen aufzudecken, die heute in allen Bereichen des täglichen Lebens vorherrschen.

Die moderne Gesellschaft befindet sich am Schnittpunkt zweier entscheidender Fragen: Was bedeutet es, wenn künstliche Intelligenz zunehmend unsere Freiheitsrechte bestimmt? Und was sind die Konsequenzen für die Menschen, gegen die AI voreingenommen ist? Die MIT Media Lab-Forscherin Joy Buolamwini hat im Rahmen ihres Studiums erkennen müssen, dass viele Gesichtserkennungstechnologien dunkelhäutige Gesichter nicht richtig wahrnehmen oder die Gesichter von Frauen nicht richtig klassifizieren. In der Folge untersucht sie die weit verbreitete Voreingenommenheit in Algorithmen. Wie sich herausstellt, ist künstliche Intelligenz alles andere als neutral. Frauen sind im Kampf gegen diese Voreingenommenheit führend, und versuchen sicherzustellen, dass unsere Bürgerrechte geschützt werden.

Die Harvard Business Review schreibt: “Eine der größten Quellen unserer Angst vor AI ist nicht, dass sie sich gegen uns wenden wird, sondern dass wir einfach nicht verstehen können, wie sie funktioniert. Die Lösung für Systeme, die Frauen bei Kreditanträgen diskriminieren oder rassistische Empfehlungen bei der Verurteilung von Straftätern aussprechen oder die Anzahl schwarzer Patienten, die als besonders pflegebedürftig identifiziert werden, scheint „erklärbare AI“ zu sein. Aber ist es nicht genausso wichtig zu verstehen, „warum“ ein Algorithmus eine Entscheidung getroffen hat, wie die Frage „wofür“ er überhaupt optimiert wurde?”

In vielen großen Unternehmen werden grundlegend wichtige Entscheidungen wie z. B. Personalentscheidungen von künstlicher Intelligenz getroffen. Wer wird zu Vorstellungsgesprächen eingeladen, wer wird gekündigt? Coded Bias zeigt, dass sich das Wissen der künstlichen Intelligenz aus den Erfahrungen der Vergangenheit speist und so eine positive Weiterentwicklung hin zu einer vorurteilsfreien Zukunft verhindert wird.

„Wenn man an AI denkt, glaubt man, sie agiert zukunftsorientiert. Aber AI basiert auf Daten, und Daten sind ein Spiegelbild unserer Geschichte.“

Joy Buolamwini

Der breite Einsatz von AI wird eine immense Herausforderung für Führungskräfte sein. Sie werden offenlegen müssen, welche menschlichen Entscheidungen hinter dem Design ihrer AI-Systeme stehen, welche ethischen und sozialen Belange sie berücksichtigt haben, woher und mit welchen Methoden sie ihre Trainingsdaten beschafft haben und wie gut sie die Ergebnisse dieser Systeme auf Spuren von Voreingenommenheit oder Diskriminierung überwacht haben. Unternehmen brauchen Modelle, denen sie vertrauen können. Das Erreichen von Transparenz bei AI-Systemen ist von entscheidender Bedeutung. Aber das Blackbox-Problem der Künstlichen Intelligenz basiert auf der Unfähigkeit, vollständig zu verstehen, warum die Algorithmen hinter der AI so funktionieren, wie sie es tun.